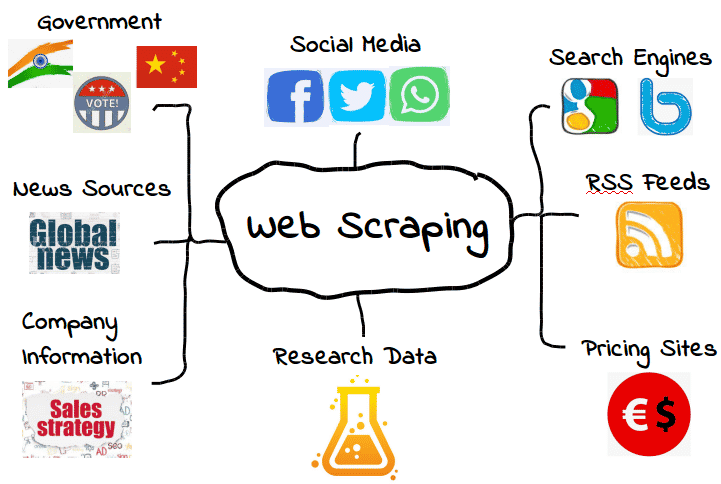

El web scraping es una técnica que se utiliza para recopilar datos públicos de sitios web y convertirlos a formatos estructurados para su análisis. Desempeña un papel fundamental en la investigación competitiva, el análisis de mercado y la toma de decisiones basada en datos en diversos sectores. Este artículo explica cómo funciona el web scraping, su importancia en el mercado actual y cómo se aplica en situaciones reales.

1. Comprender el Web Scraping y su importancia en el mercado actual

El web scraping se reconoce cada vez más como un método fundamental para recopilar grandes volúmenes de datos públicos de la web.

En lugar de ser una técnica aislada para extraer información de páginas individuales, ahora desempeña un papel fundamental en los flujos de trabajo de recopilación de datos estructurados que utilizan empresas, investigadores y equipos digitales de diversos sectores.

A medida que las organizaciones priorizan el análisis basado en datos, la web abierta se ha convertido en una de las fuentes más dinámicas y completas de información real.

Los sitios web publican continuamente datos sobre precios, comportamiento de los usuarios, reseñas, noticias y actividad del mercado, lo que hace que los datos web sean esenciales para comprender las tendencias cambiantes y los entornos competitivos.

El web scraping permite recopilar esta información de forma consistente y escalable, transformando el contenido web no estructurado en conjuntos de datos utilizables.

La creciente adopción de inteligencia artificial, análisis de big data y sistemas de toma de decisiones automatizados ha incrementado aún más la demanda de datos web fiables.

Estos sistemas dependen de grandes conjuntos de datos que se actualizan con frecuencia para funcionar eficazmente, y la recopilación manual de datos ya no es práctica a gran escala.

Como resultado, el web scraping suele integrarse en procesos automatizados diseñados para operar de forma continua y con mínima intervención humana.

Al mismo tiempo, los entornos web modernos se han vuelto más complejos. Los sitios web implementan cada vez más mecanismos antibots, límites de velocidad y controles de acceso, lo que plantea nuevos desafíos para la recopilación de datos a gran escala.

Por lo tanto, un web scraping eficaz hoy en día requiere no solo comprender las técnicas básicas de extracción, sino también la capacidad de gestionar sesiones, cuentas y entornos de navegador de forma estable y sostenible.

Comprender este contexto más amplio ayuda a aclarar por qué el raspado web se ha convertido en una capacidad esencial en el mercado actual y sienta las bases para explorar sus principios básicos, estrategias de automatización y aplicaciones del mundo real en las secciones que siguen.

1.1. Fundamentos del Web Scraping

El web scraping sirve de puente entre las empresas y la enorme cantidad de datos disponibles en internet. Al aprovechar la automatización, las organizaciones pueden extraer información relevante de los sitios web de forma eficiente, sin recurrir a procesos manuales que consumen mucho tiempo y son propensos a errores. Este enfoque permite recopilar datos a gran escala y transformarlos en formatos adecuados para el análisis y la toma de decisiones.

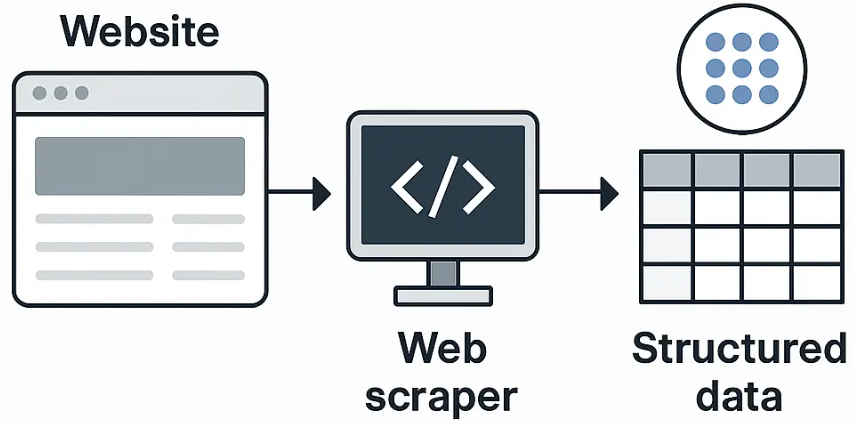

En esencia, el web scraping implica varios pasos fundamentales:

- Extracción de datos: Las herramientas automatizadas envían solicitudes a páginas web y recuperan información específica según parámetros predefinidos.

- Análisis HTML: una vez recopilado el contenido, los raspadores analizan la estructura HTML de las páginas web para localizar y aislar puntos de datos relevantes.

- Formato de salida: los datos extraídos luego se convierten en formatos estructurados, como hojas de cálculo, bases de datos o archivos JSON, para su uso posterior.

La capacidad de automatizar estos pasos representa una evolución significativa en la recopilación de datos, permitiendo transformar el contenido web sin procesar en información procesable de manera consistente y repetible.

Web scraping vs. web crawling

El web scraping se confunde a menudo con el web crawling, pero ambos conceptos tienen propósitos diferentes. El web crawling se centra principalmente en descubrir y navegar por páginas web siguiendo enlaces, generalmente para crear un índice del contenido disponible. Los motores de búsqueda dependen en gran medida de los rastreadores para comprender las estructuras de los sitios web e identificar páginas nuevas o actualizadas.

El web scraping , en cambio, se centra en extraer datos específicos de páginas web conocidas. Mientras que el rastreo responde a la pregunta "¿Qué páginas existen?" , el scraping aborda la pregunta "¿Qué información se puede extraer de estas páginas?" . En muchos sistemas reales, el rastreo y el scraping se utilizan conjuntamente, pero sus objetivos y resultados son distintos.

Web scraping vs. APIs

Otra distinción importante es entre el web scraping y el uso de interfaces de programación de aplicaciones (API). Las API proporcionan acceso estructurado y con soporte oficial a los datos, a menudo con documentación clara, límites de uso y campos de datos predefinidos. Cuando una API está disponible y es lo suficientemente completa, suele ser la opción más estable y compatible.

Sin embargo, las API pueden exponer solo conjuntos de datos limitados, restringir el acceso o no estar disponibles para ciertas plataformas. En tales casos, el web scraping se convierte en una alternativa práctica cuando los datos son de acceso público en páginas web, pero no están completamente disponibles a través de las API , o cuando se requiere mayor flexibilidad.

Cuándo utilizar el web scraping y cuándo utilizar las API

El web scraping es más adecuado para escenarios que involucran datos visibles públicamente que cambian con frecuencia o abarcan varias páginas y fuentes, como precios competitivos, listados de productos, reseñas de clientes o contenido de noticias. Las API son más adecuadas para situaciones que requieren estabilidad a largo plazo, estructuras de datos garantizadas y canales de acceso oficiales.

Comprender estas diferencias ayuda a aclarar el papel del web scraping como método complementario de recopilación de datos, en lugar de sustituir a los sistemas de rastreo o las API. Esta base es esencial para explorar las estrategias y los desafíos de la automatización en las siguientes secciones.

1.2. El papel de la automatización en el Web Scraping

La automatización desempeña un papel fundamental en el web scraping moderno, ya que permite recopilar datos de forma más rápida, consistente y a una escala mucho mayor que con los métodos manuales. En lugar de depender de la interacción humana, los sistemas de scraping automatizado pueden acceder continuamente a sitios web, extraer datos predefinidos y procesar información con mínima intervención. Esto reduce significativamente el tiempo y el esfuerzo operativo, especialmente al trabajar con fuentes de datos que se actualizan con frecuencia o con un gran volumen.

Al automatizar tareas repetitivas como la navegación de páginas, la extracción de datos y el formateo, las organizaciones pueden mantener conjuntos de datos actualizados y minimizar los errores humanos. La automatización también permite estandarizar los procesos de scraping, lo que aumenta la fiabilidad de los resultados y facilita su integración en flujos de trabajo posteriores de análisis o inteligencia empresarial.

Automatización en diferentes niveles

La automatización en el web scraping se puede implementar en distintos niveles de complejidad, dependiendo del alcance y los objetivos del proyecto:

- Scripts simples: Automatización básica mediante scripts ligeros para extraer datos de un número limitado de páginas estáticas. Este enfoque es adecuado para tareas a pequeña escala o para la recopilación de datos puntual.

- Extracción programada: trabajos automatizados que se ejecutan a intervalos predefinidos para recopilar datos actualizados, como controles de precios diarios o monitoreo periódico de contenido.

- Canalizaciones de extracción a gran escala: Sistemas avanzados diseñados para recopilar datos de miles de páginas, plataformas o cuentas. Estas canalizaciones suelen implicar cargas de trabajo distribuidas, gestión de errores, registro y validación de datos para garantizar un funcionamiento continuo.

A medida que el scraping pasa de scripts simples a pipelines a gran escala, la automatización se vuelve esencial para mantener la eficiencia y la escalabilidad.

Sin embargo, el aumento de la automatización también presenta nuevos desafíos. El comportamiento de scraping altamente automatizado puede parecer repetitivo y no humano, lo que facilita que los sitios web detecten y bloqueen dicha actividad. Las solicitudes frecuentes, los patrones predecibles y la reutilización de las características del navegador pueden activar sistemas antibots, límites de velocidad o restricciones de cuenta.

Para operar de forma fiable a gran escala, los sistemas de scraping automatizado deben gestionar múltiples factores técnicos, como la rotación de IP, la consistencia de las huellas dactilares del navegador y la gestión de sesiones . Sin un control adecuado de estos elementos, incluso los flujos de trabajo de scraping bien diseñados pueden volverse inestables o efímeros. Por ello, el web scraping moderno depende cada vez más de entornos de navegador controlados y de la gestión de identidades, en lugar de la automatización por sí solo.

A pesar de sus ventajas, el web scraping conlleva desafíos. No todos los sitios web lo permiten, y algunos implementan medidas para bloquearlo. Las empresas deben actuar con cautela para garantizar el cumplimiento de las normas legales y éticas al realizar trabajos de web scraping.

Además, basarse únicamente en datos extraídos sin una validación adecuada puede llevar a conclusiones inexactas. Por lo tanto, combinar los datos extraídos con otras metodologías de investigación puede mejorar significativamente la toma de decisiones y la formulación de estrategias.

2. Desafíos y consideraciones éticas del Web Scraping

A pesar de sus ventajas, el web scraping presenta diversos desafíos técnicos, legales y éticos que las organizaciones deben gestionar con cuidado. A medida que los sitios web protegen cada vez más sus datos y las regulaciones sobre su uso se vuelven más estrictas, el web scraping ya no es una tarea puramente técnica, sino una que requiere planificación estratégica y una ejecución responsable.

2.1. Desafíos técnicos del web scraping

Desde un punto de vista técnico, una de las principales dificultades del web scraping es la variabilidad de los sitios web. Las estructuras de las páginas pueden cambiar sin previo aviso, el contenido renderizado en JavaScript puede complicar la extracción y el marcado HTML inconsistente puede generar conjuntos de datos incompletos o dañados. Estos problemas requieren la supervisión y el mantenimiento continuos de los flujos de trabajo de scraping para garantizar la precisión y la estabilidad de los datos.

Además, las limitaciones de rendimiento, como demoras en las solicitudes, tiempos de espera del servidor e inestabilidad de la red, pueden afectar las operaciones de raspado a gran escala, especialmente cuando es necesario recopilar datos con frecuencia o en tiempo real.

2.2. Mecanismos anti-scraping y de detección

Muchos sitios web implementan activamente sistemas anti-scraping y de detección de bots para controlar el acceso automatizado. Entre las medidas comunes se incluyen los desafíos CAPTCHA, el análisis del comportamiento del navegador y servicios de protección contra bots como Cloudflare. Estos sistemas están diseñados para identificar patrones de tráfico no humanos y restringir o bloquear solicitudes sospechosas.

Otra práctica generalizada es el bloqueo de IP y la limitación de velocidad , donde se deniegan temporal o permanentemente las solicitudes excesivas o repetitivas de la misma fuente. Sin una gestión adecuada de los patrones de acceso, las direcciones IP y los entornos de los navegadores, las actividades de scraping pueden volverse rápidamente inestables o ineficaces.

2.3. Consideraciones legales y éticas

Más allá de las barreras técnicas, el web scraping plantea importantes cuestiones legales y éticas. No todos los sitios web permiten la recopilación automatizada de datos, y algunos lo prohíben explícitamente en sus términos de servicio . Ignorar estas políticas puede exponer a las empresas a riesgos legales o interrupciones del servicio.

El archivo robots.txt también desempeña un papel clave en la definición del acceso automatizado aceptable, al indicar qué secciones de un sitio web están destinadas a bots y cuáles están restringidas. Si bien no es legalmente vinculante en todas las jurisdicciones, robots.txt se considera ampliamente un estándar ético que las prácticas de scraping responsables deben respetar.

En los casos en que los datos extraídos incluyen información personal o identificable, las normativas de privacidad de datos, como el RGPD, introducen requisitos de cumplimiento adicionales. Incluso los datos públicos pueden estar sujetos a normas que regulan su recopilación, almacenamiento y procesamiento.

2.3. Precisión y validación de los datos

Finalmente, basarse únicamente en datos extraídos sin una validación adecuada puede llevar a conclusiones inexactas o engañosas. Los datos web pueden contener duplicados, información obsoleta o ruido contextual que afecta la calidad del análisis. Para mitigar estos riesgos, los datos extraídos suelen combinarse con otros métodos de investigación, como encuestas, datos propios o verificación manual, para mejorar la fiabilidad y facilitar la toma de decisiones acertadas.

3. Aplicaciones del Web Scraping en diversas industrias

El web scraping no se limita a recopilar datos de sitios web. Su verdadero valor reside en cómo se procesan, analizan y utilizan esos datos para respaldar la toma de decisiones informada. En diferentes sectores, el web scraping ayuda a transformar datos web sin procesar en información que impulsa la estrategia, las operaciones y el desarrollo de productos.

3.1. Comercio electrónico y análisis competitivo

La industria del comercio electrónico ha revolucionado el modo en que operan las empresas, y el web scraping juega un papel fundamental a la hora de dar forma a las estrategias de marketing y optimizar las decisiones.

Extraer datos de productos de los sitios web de la competencia permite a las empresas comprender las estructuras de precios, las tácticas promocionales y los niveles de inventario. Esta información es crucial para formular estrategias de precios competitivas que maximicen las ganancias y atraigan clientes.

Además, al analizar las opiniones y calificaciones de los clientes de varias plataformas, las empresas pueden obtener información sobre las preferencias de los consumidores, lo que conduce a un mejor desarrollo de productos y dirección de marketing.

La integración del web scraping en los flujos de trabajo de comercio electrónico permite a las empresas mantenerse al tanto de las tendencias del mercado y adaptarse rápidamente, lo que garantiza un crecimiento sostenido en un panorama en constante evolución.

Cómo funciona en la práctica

El web scraping se utiliza generalmente como un proceso de monitorización continua, en lugar de una extracción única de datos. Las empresas recopilan precios de productos, disponibilidad e información promocional de los sitios web de la competencia y luego almacenan estos datos a lo largo del tiempo para crear conjuntos de datos históricos de precios. Estos conjuntos de datos permiten a los equipos comparar tendencias de precios, detectar cambios repentinos y ajustar sus propios precios o promociones en consecuencia.

Sin embargo, las plataformas de comercio electrónico se encuentran entre los entornos más protegidos contra la recopilación automatizada de datos. Las solicitudes frecuentes, los patrones de navegación repetitivos y las huellas digitales idénticas del navegador pueden activar rápidamente los sistemas anti-bots, lo que resulta en el bloqueo de IP o la restricción de cuentas. Para mantener la estabilidad de la recopilación de datos, las operaciones de scraping suelen requerir la rotación de IP, la gestión de sesiones y perfiles de navegador aislados para imitar el comportamiento real del usuario y reducir el riesgo de detección.

3.2. Investigación de mercado y conocimiento del consumidor

Una investigación de mercado de calidad es vital para el éxito empresarial. El web scraping permite a las organizaciones obtener datos precisos y exhaustivos que impulsan la toma de decisiones informadas. Al aprovechar los datos web scraping, las empresas pueden analizar eficazmente las tendencias de consumo y determinar qué productos conectan con su público objetivo.

Por ejemplo, monitorear la opinión en redes sociales sobre marcas o productos específicos ayuda a las empresas a evaluar la percepción del público e identificar posibles áreas de mejora. Con datos estructurados obtenidos mediante web scraping, las empresas pueden optimizar sus puntos de entrada a nuevos mercados y refinar su oferta.

Además, el web scraping facilita la monitorización de la competencia, monitorizando sus lanzamientos, promociones y posicionamiento en el mercado. Esta información permite a las empresas innovar y desarrollar estrategias acordes, manteniéndose a la vanguardia en un mercado competitivo.

Convertir datos sin procesar en información sobre el consumidor

En la investigación de mercados, el web scraping se utiliza ampliamente para recopilar datos no estructurados de reseñas de productos, foros de discusión y redes sociales donde los consumidores comparten abiertamente sus opiniones y experiencias. En comparación con los conjuntos de datos estructurados, este tipo de datos proporciona un contexto más completo, pero también introduce ruido significativo, como spam, contenido duplicado y conversaciones irrelevantes.

Para extraer información significativa, los datos extraídos deben limpiarse, filtrarse y normalizarse antes de su análisis. Una vez procesados, pueden combinarse con técnicas de análisis de sentimientos para identificar puntos débiles comunes, preferencias emergentes y cambios en la percepción del consumidor a lo largo del tiempo. Este enfoque permite a las empresas ir más allá de las métricas superficiales y comprender mejor cómo se sienten realmente los clientes respecto a los productos, las marcas y las tendencias del mercado.

3.3. Recopilación de datos inmobiliarios

El sector inmobiliario es otro ámbito donde el web scraping destaca. Los agentes y corredores recurren cada vez más a herramientas de web scraping para alimentar sus bases de datos con listados de propiedades actualizados e información de alquiler. Esta práctica les permite desarrollar análisis de mercado exhaustivos que fundamentan sus decisiones comerciales.

Al recopilar y analizar las tasas de vacancia, las tendencias de precios y los tipos de propiedad, los profesionales inmobiliarios pueden realizar predicciones fundamentadas sobre la trayectoria del mercado. Además, comprender la rentabilidad de los alquileres y el valor de las propiedades mediante datos recopilados permite a los agentes ofrecer evaluaciones precisas a los clientes.

El raspado web ayuda a los agentes inmobiliarios a combatir la competencia al garantizar que tengan los datos más recientes a su alcance, lo que les permite atender a los clientes de manera eficaz y eficiente.

Recopilación de datos a largo plazo en el sector inmobiliario

El web scraping se utiliza comúnmente para recopilar información estructurada, como precios de propiedades, ubicaciones, estado de las propiedades y cambios históricos a lo largo del tiempo. Al rastrear cómo aparecen, desaparecen o cambian los precios de las propiedades, las empresas pueden analizar las tendencias del mercado, estimar la demanda e identificar posibles oportunidades de inversión a nivel local y regional.

Los sitios web inmobiliarios suelen implementar potentes mecanismos antibots para proteger datos valiosos, como límites de tasa de solicitudes, análisis de comportamiento y sistemas avanzados de detección de bots. Dado que la información valiosa en este sector depende de la recopilación de datos a largo plazo y recurrente, las operaciones de scraping deben diseñarse para ejecutarse de forma programada, manteniendo un acceso estable. Esto hace que la consistencia, el control de sesiones y el aislamiento de identidades sean factores cruciales para una extracción fiable de datos inmobiliarios.

3.4. Monitoreo de noticias y análisis del sector

Las actualizaciones de noticias oportunas pueden tener un impacto significativo en empresas de todos los sectores. Las empresas necesitan mantenerse informadas sobre los avances de su sector para adaptarse correctamente cuando sea necesario. El web scraping ofrece una solución eficaz para monitorizar las fuentes de noticias y recopilar informes críticos.

Al automatizar el proceso de recopilación de artículos y fragmentos de noticias, las empresas pueden crear resúmenes detallados de tendencias emergentes, cambios regulatorios y fluctuaciones del mercado. Esta capacidad es especialmente relevante para empresas muy afectadas por la actualidad o que requieren una vigilancia constante de su reputación.

Además, el web scraping puede agilizar el proceso de investigación para los profesionales que buscan información sobre informes del sector, libros blancos y opiniones de analistas. Al recopilar toda la información relevante en un solo lugar, las empresas pueden optimizar sus estrategias de planificación y mitigar posibles riesgos.

Garantizar la calidad de los datos en el seguimiento de noticias

En el monitoreo de noticias, el web scraping puede implementarse tanto en tiempo real como en modelos programados, según la rapidez con la que se necesite capturar la información. El web scraping en tiempo real se utiliza a menudo para noticias de última hora y detección de tendencias, mientras que el web scraping programado facilita el análisis a largo plazo del sector y el seguimiento de contenido.

Un desafío clave en este contexto es evitar el contenido duplicado, ya que una misma noticia puede aparecer en múltiples fuentes o distribuirse con pequeñas variaciones. Para mantener la calidad de los datos, el contenido extraído debe deduplicarse, categorizarse y enriquecerse con etiquetas relevantes como tema, sector, fecha de publicación y credibilidad de la fuente. Estos pasos permiten a las organizaciones transformar grandes volúmenes de datos de noticias en inteligencia estructurada que facilita el análisis competitivo, la monitorización de riesgos y la planificación estratégica.

4. Aprovechar el poder del Web Scraping para el análisis de reseñas

Las reseñas de clientes representan uno de los formatos de datos no estructurados más completos disponibles en línea. A diferencia de las métricas numéricas, las reseñas capturan opiniones, emociones y experiencias detalladas que son difíciles de cuantificar sin un procesamiento sistemático.

El web scraping permite a las empresas recopilar esta retroalimentación a gran escala y convertir comentarios dispersos en conjuntos de datos estructurados. Al combinarse con técnicas de limpieza y análisis de datos, los datos de reseñas extraídos pueden revelar tendencias de opinión, problemas recurrentes y oportunidades de mejora que podrían no ser visibles mediante métodos de investigación tradicionales.

4.1. Recopilación de opiniones de usuarios en redes sociales

Las redes sociales son un tesoro de contenido generado por los usuarios, incluyendo reseñas y comentarios sobre productos o servicios. Mediante el web scraping, las empresas pueden recopilar sistemáticamente esta valiosa retroalimentación, lo que les permite identificar fortalezas y debilidades.

Por ejemplo, una tienda de moda puede recopilar reseñas de plataformas como Instagram, Twitter y Facebook para evaluar la opinión de los clientes sobre productos específicos. El análisis de estos datos revela temas predominantes y establece conexiones entre las experiencias de los clientes y su comportamiento de compra.

Gracias a estos conocimientos, las empresas pueden mejorar sus productos y optimizar sus estrategias de marca, fomentando en última instancia la fidelidad de los clientes.

Desafíos prácticos del scraping en plataformas de redes sociales

La recopilación de comentarios de los usuarios en redes sociales presenta desafíos únicos en comparación con los sitios web tradicionales. La mayoría de las plataformas requieren que los usuarios inicien sesión, aplican el acceso por sesión e imponen límites estrictos sobre la cantidad de datos que se pueden ver o recopilar de una sola cuenta en un plazo determinado. Estas restricciones están diseñadas para prevenir comportamientos automatizados y proteger la integridad de la plataforma.

Como resultado, el scraping a gran escala de redes sociales suele requerir la gestión de múltiples cuentas, el mantenimiento de sesiones activas y la operación en entornos de navegador aislados. El uso de diferentes perfiles de navegador ayuda a simular el comportamiento real del usuario, reducir la correlación entre cuentas y minimizar el riesgo de detección o suspensión de cuentas. Sin una gestión adecuada de perfiles y entornos, los flujos de trabajo de scraping de redes sociales tienden a volverse inestables y difíciles de escalar.

4.2. Análisis del sentimiento competitivo

Comprender la percepción pública de las marcas competidoras es igualmente importante. El web scraping permite a las empresas recopilar y analizar reseñas de diversas fuentes, lo que les ayuda a comprender la opinión de los consumidores sobre la competencia.

Seguimiento de las tendencias de sentimiento a lo largo del tiempo

El análisis del sentimiento competitivo cobra mayor valor cuando se rastrea a lo largo del tiempo, en lugar de analizarlo como instantáneas aisladas. Al recopilar continuamente reseñas, comentarios y menciones de marcas competidoras, las empresas pueden visualizar cómo cambia la percepción del público en respuesta a lanzamientos de productos, cambios de precios, incidentes de atención al cliente o campañas de marketing.

Los datos extraídos pueden combinarse con técnicas de procesamiento del lenguaje natural (PLN) para categorizar el sentimiento y comparar la marca A con la marca B en períodos de tiempo consistentes. Este enfoque ayuda a identificar no solo qué marca tiene un mejor rendimiento general, sino también cuándo y por qué surgen brechas de sentimiento, lo que permite tomar decisiones estratégicas más informadas basadas en la opinión real de los consumidores.

Este análisis del sentimiento competitivo permite a las empresas identificar las áreas donde sus rivales destacan y dónde fallan. Por ejemplo, si un competidor recibe elogios constantes por su servicio al cliente, esta información puede inspirar a las empresas a mejorar sus propios estándares de servicio, lo que podría atraer a clientes insatisfechos que buscan alternativas.

Al adoptar los conocimientos obtenidos del análisis de reseñas, las empresas pueden adoptar un enfoque proactivo para abordar la percepción pública y mejorar su posición en el mercado.

4.3. Impulsar las decisiones de desarrollo de productos

Con la información obtenida del web scraping, las empresas pueden usar la opinión de los consumidores para tomar decisiones sobre el desarrollo de sus productos. Identificar quejas o sugerencias comunes permite a los equipos innovar basándose en las necesidades reales de los consumidores, en lugar de en suposiciones.

Por ejemplo, una empresa tecnológica podría analizar los comentarios de los usuarios sobre la duración de la batería de un modelo de smartphone. Al identificar este problema, la empresa puede centrarse en mejorar el rendimiento de la batería en futuras versiones, aumentando así la satisfacción del cliente y la fidelidad a la marca.

En esencia, aprovechar el raspado web para el análisis de reseñas fomenta una cultura de capacidad de respuesta dentro de las organizaciones, lo que les permite evolucionar continuamente de acuerdo con las demandas de los consumidores.

De los conocimientos a las decisiones sobre productos

Cuando los datos de las reseñas se recopilan y analizan sistemáticamente, pueden influir directamente en las decisiones de desarrollo de productos. Las quejas recurrentes sobre características específicas, problemas de usabilidad o funcionalidades faltantes suelen indicar áreas que requieren mejoras. Por el contrario, la retroalimentación positiva constante puede validar las decisiones de diseño existentes o destacar puntos fuertes que conviene reforzar.

En este flujo de trabajo, el web scraping actúa como la base de un proceso de toma de decisiones más amplio: los datos se recopilan a partir de reseñas, se transforman en información estructurada mediante análisis y, finalmente, se traducen en acciones concretas, como actualizaciones de funciones, ajustes de precios o cambios en el posicionamiento del producto. Este ciclo de conocimiento a acción permite a los equipos de producto basar sus decisiones en comentarios reales de los usuarios, en lugar de suposiciones o encuestas limitadas.

5. Conclusión

El web scraping se ha convertido en un activo estratégico para las empresas que buscan operar en entornos basados en datos. En sectores como el comercio electrónico, el sector inmobiliario, la investigación de mercados y el monitoreo de medios, permite a las organizaciones recopilar información oportuna, descubrir patrones y tomar decisiones informadas basadas en datos reales, en lugar de suposiciones.

A medida que las operaciones de scraping escalan, el éxito depende no solo de las técnicas de extracción, sino también de la recopilación responsable de datos y su mantenimiento a lo largo del tiempo. La automatización, las consideraciones éticas y la interpretación precisa de los datos desempeñan un papel fundamental para garantizar que los datos scraping sigan siendo fiables y procesables.

Además, el scraping web a gran escala se enfrenta cada vez más a barreras técnicas como el bloqueo de IP, el análisis de comportamiento y los sistemas antibots.

Para mantener flujos de trabajo de scraping estables y a largo plazo, las empresas suelen necesitar una infraestructura que pueda gestionar múltiples cuentas, aislar entornos de navegador y reducir el riesgo de detección. Las soluciones de navegador antidetección como Hidemyacc ayudan a abordar estos desafíos operativos al proporcionar perfiles de navegador independientes y una gestión flexible de IP, lo que permite que los procesos de recopilación de datos se ejecuten de forma más segura y consistente.

Al combinarse con una estrategia de scraping bien diseñada, estas herramientas permiten a las organizaciones aprovechar al máximo el potencial de los datos web y minimizar las interrupciones.

Diseñado para el raspado web a gran escala

Apoye la recopilación de datos automatizada a largo plazo con entornos de navegador aislados y una gestión de identidad flexible.

Explorar HidemyaccSi tiene más preguntas, comentarios o sugerencias, no dude en contactarnos a través del soporte de Telegram, Skype o Facebook Messenger.

Más sobre este tema:

- Herramienta gratuita de raspado web con inteligencia artificial: ¿cuáles son las mejores herramientas para sus proyectos?

- Rastreo de eBay: herramientas, consejos y mejores prácticas para principiantes

- ¿Qué es Antidetect Browser ? La herramienta de privacidad que supera a las VPN.

6. FAQ

¿Es legal el web scraping?

El web scraping en sí no es ilegal, pero su legalidad depende de cómo y dónde se utilice. Algunos sitios web prohíben explícitamente la recopilación automatizada de datos en sus términos de servicio, mientras que otros permiten un acceso limitado. Las empresas siempre deben revisar las políticas de su sitio web, respetar las directrices de robots.txt y evitar la recopilación de datos personales o sensibles sin la debida autorización para cumplir con los estándares legales y éticos.

¿Cuál es la diferencia entre el web scraping y el web crawling?

El rastreo web se centra en descubrir e indexar páginas web, a menudo para motores de búsqueda, mientras que el raspado web está diseñado para extraer datos específicos de dichas páginas. Los rastreadores mapean la estructura de la web, mientras que los raspadores se centran en puntos de datos definidos, como precios, reseñas o listados, para fines de análisis y toma de decisiones.

¿Por qué los sitios web bloquean las actividades de raspado web?

Los sitios web pueden bloquear el scraping para proteger los recursos del servidor, evitar el uso indebido de datos o mantener ventajas competitivas. Los mecanismos de bloqueo más comunes incluyen la limitación de la velocidad de IP, las pruebas CAPTCHA, el análisis de huellas dactilares del navegador y los sistemas de detección basados en el comportamiento. Estas medidas son especialmente comunes en plataformas de comercio electrónico, redes sociales y bienes raíces.

¿Cómo pueden las empresas reducir el riesgo de ser detectadas mientras extraen datos?

Reducir el riesgo de detección generalmente implica gestionar la frecuencia de las solicitudes, rotar las direcciones IP, mantener un comportamiento de navegación realista y aislar las sesiones en diferentes entornos de navegador. El uso de perfiles de navegador independientes ayuda a evitar la correlación entre las actividades de scraping, lo que aumenta la estabilidad de la recopilación de datos a gran escala y a largo plazo.

¿Cuándo el web scraping es una mejor opción que el uso de API?

El web scraping se utiliza a menudo cuando las API no están disponibles, son limitadas, costosas o no ofrecen el nivel de detalle requerido. Las API son ideales para el acceso estructurado y basado en permisos, mientras que el web scraping ofrece flexibilidad para extraer datos públicos a los que no se puede acceder mediante interfaces oficiales.

¿Puede el web scraping respaldar una estrategia empresarial a largo plazo?

Sí. Cuando se implementa de forma responsable, el web scraping facilita la monitorización continua del mercado, el análisis competitivo, el seguimiento de las opiniones y la optimización de productos. La clave está en la consistencia y la calidad de los datos: el web scraping debe formar parte de un flujo de datos continuo, no ser una tarea puntual.